SSTIC 2018

Nous sommes en 2018. Fuites de données, attaques massives,

failles structurelles, le monde constate chaque jour un peu plus à quel point

la sécurité est un échec.

Un petit village gaulois en quête d’attention résiste encore

à l’évidence dans cet

article consacré à la conférence SSTIC 2018 (ainsi que l’édito du magazine

MISC qui s’en suit). Car en cette période de défiance envers les médias

institutionnels et les preuves scientifiques, le public affectionne la pensée

dissidente : elle a l’apparence de la sincérité.

Fin de l’histoire. Ou presque.

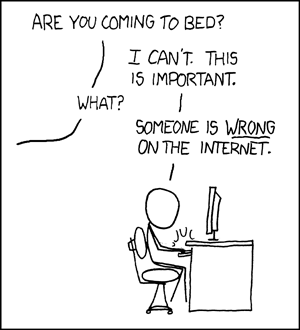

Je ne prends pas la plume pour lutter contre les #FakeNews. Je

ne prends pas la plume car someone is

wrong on the Internet. Je prends la plume pour me défendre contre les attaques ad hominem dont je suis la cible.

« Ceux qui soutiennent [que la sécurité est un échec] sont bien souvent des personnes qui n’ont jamais essayé de construire quoi que ce soit, de développer un produit. »

Faut-il avoir tué quelqu’un pour être contre la guerre ?

Mme Michu n’est-elle pas légitime à se plaindre des lenteurs de son ordinateur

et du vol de ses mots de passe, sous prétexte qu’elle n’a jamais appris la

programmation ?

Faut-il établir une échelle de valeurs ? Un éditeur de

produits de sécurité est-il plus légitime à s’exprimer sur la cyber qu’un reverse-engineer ?

Ces arguments spécieux ne méritent pas qu’on s’attache plus longtemps à leur réfutation. Mais j’irai plus loin en affirmant que le

principal frein à l’amélioration du niveau de sécurité global est justement l’écosystème

de la sécurité (consultants, éditeurs de produits, et les conférences qu’ils

organisent).

« Qui vit de combattre un ennemi a tout intérêt de le laisser en vie. »

La sécurité est un milieu hermétique, impénétrable au commun

des mortels, qui vit sur ses rites et ses codes – une conférence comme SSTIC en

étant la caricature. Le reverse-engineering

est la discipline reine, la sécurité JavaCard s’apparente à la fée Carabosse,

tandis que le juridique et l’analyse de risque ont été exclus de la famille. Sans

parler de la privacy ou des méthodes de

développement sécurisé, dont personne ne se soucie dans le sérail.

Les combats qui mèneront à la nobilité ont été figés par nos

aïeuls, et les experts en sécurité se doivent de consacrer leur énergie à des

sujets futiles tels que la longueur des mots de passe ou la sécurité des clés

USB (sujet récurrent du SSTIC s’il en est). Un travail bien dérisoire tandis

que la première cause d’intrusion reste le phishing

– sujet malheureusement beaucoup plus ardu et moins valorisant à traiter.

Heureusement, des professionnels de l’informatique (mais pas de la sécurité) s’y

attaquent via U2F et WebAuthn.

« Il n'est pas de problème qu'une absence de solution ne finisse par résoudre. »

Quant aux éditeurs de produits de sécurité, ils ne font qu’ajouter

de la complexité à l’écheveau logiciel. L’essence de la sécurité c’est la

simplification : moins de lignes de code, moins de dépendances tierce

partie, moins d’interfaces, moins de mots de passe. Rien de pire que d’interpréter

dans plusieurs logiciels différents un format de fichier ou une requête HTTP.

Il y aurait beaucoup à dire sur la valeur des conseils

prodigués par les experts en sécurité – tels que d’utiliser plusieurs logiciels

antivirus différents au sein d’un même réseau – mais on me souffle que ce sujet

pourrait faire l’objet d’une conférence à SSTIC. C’est aussi là l’une des clés

du problème : les experts en sécurité sont bien trop fiers pour admettre

qu’ils ont tort (ou que le monde a changé). Ils sont incapables de tirer les

leçons de leurs échecs, comme le suggère pourtant l’article susmentionné. Félicitation à

Bill

Burr pour avoir admis – à 73 ans – que la publication NIST 800-63 sur les

mots de passe était une erreur.

Pour toutes ces raisons, je suis intimement persuadé que la

sécurité est un échec. Et j’en ai eu la preuve récemment, car la sécurité n’est

pas un échec partout. Il existe des villages – certes pas gaulois – dans lesquels

tout logiciel non maitrisé est isolé.

Où le problème de la sécurité Linux

est traité de manière systématique par des équipes constituées – pas des loups

solitaires plus connus pour leurs effusions sur Twitter que pour leur capacité

à soumettre du code dans le noyau. Où des efforts considérables sont déployés

dans les comités de standardisation pour résoudre de manière définitive le

problème du XSS en transformant HTML en un langage fortement typé. Et devinez

quoi : dans cette entreprise personne ne réclame le titre de RSSI.

Quelle est la différence avec bon nombre de présentations SSTIC ? Ce

sont des équipes, pas des héros. Ce qui permet aux projets de survivre au remplacement de tous les membres de l'équipe, tandis que la majorité des outils présentés à SSTIC entrent en déshérence le jour de leur publication. Le mythe du héros solitaire (si bien représenté

par le hacker en hoodie, et perpétué par le challenge SSTIC) nous cause beaucoup de

tort aujourd’hui.

Une autre différence ? Ce sont des ingénieurs en génie logiciel, pas des stars aux compétences limitées. Et

ils ne se définissent pas comme travaillant dans le security circus ...

Alors, qu’est-ce qui a changé entre SSTIC 2003 et 2018 ?

Beaucoup de choses, à commencer par un renouvellement complet des générations. Selon

un sondage à main levée, il m’a semblé que plus de 90% de l’audience venait à

SSTIC pour la première fois. Et aucun des jeunes avec qui j’ai eu le privilège

de partager un instant social n’a jamais entendu parler de Frédéric Raynal,

Cédric Blancher, ou même Hervé Schauer.

Les vieilles légendes ont vécu. Il faut l’admettre, ou se

condamner à souffrir en s'appropriant la gloire de ce qui a été.

« Puisque ces mystères nous dépassent, feignons d'en être l'organisateur. »